Дневник c00l0ne

-

ПопулярностьТоп-273

-

Постов10,412

-

Просмотров868,488

-

Подписок73

-

Карма автора+566

-

Shtirlitz, fastdecision, Feliz, вы не представляете как вам повезло что вы это только здесь читаете,

+20

-

+17

-

Мне однажды сказали примерно следующее: -Не так страшно ,когда человек творит откровенную чушь , куд

+17

-

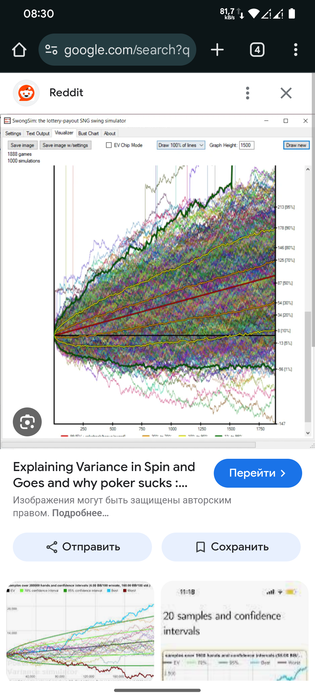

Просто умножаешь дневной выигрышь на 30, что тут сложного?

+14

-

Дык не моё-ж... Цитата , мсье Ваши , сударь , раздачи - куются фартом , нелепостью и попытками подо

+14

-

Сообщение отредактировал c00l0ne - 12.3.2025, 18:18

-

-

Таких багов очень очень много в солвере. JAK твой выход, чтот твоя машина покажет?!

-

CAHTEXHUK @ 19.03.25

JAK твой выход, чтот твоя машина покажет?!

У джака не считает стартера

Это не баг, просто эвристикой в топ 1 два флеша со сплитом пары не учитывает Олег

Обсуждали у него в ТГ уже

Пс Да и вообще чтобы нормально решить ананас всё ещё нужны тысячи ядер)))

Гриндите лучше вон мттшки, там составы фишей полный покердом, я сейчас праздники отпразную , ворвусь плотно...

-

Сходство между мозгом и LLM

-

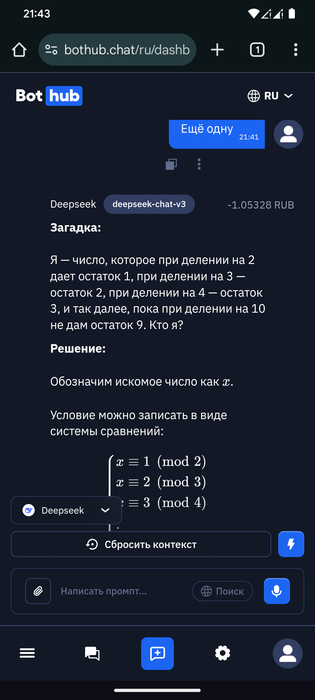

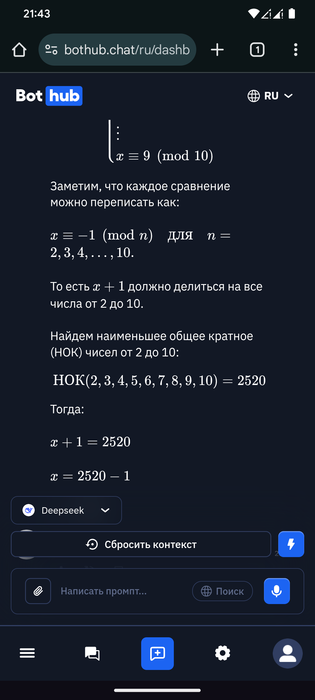

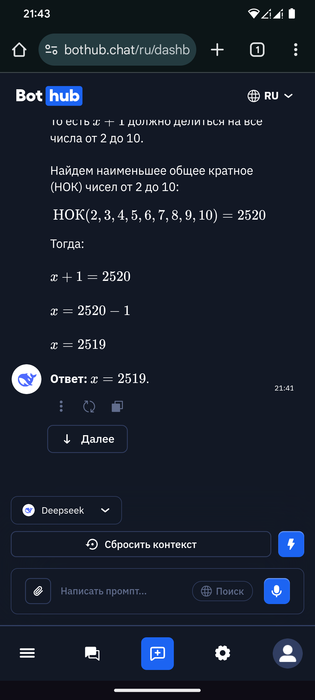

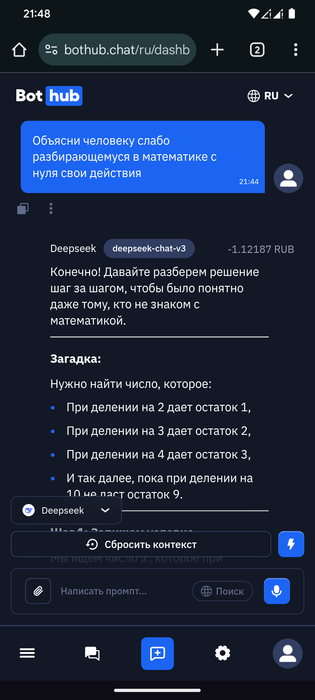

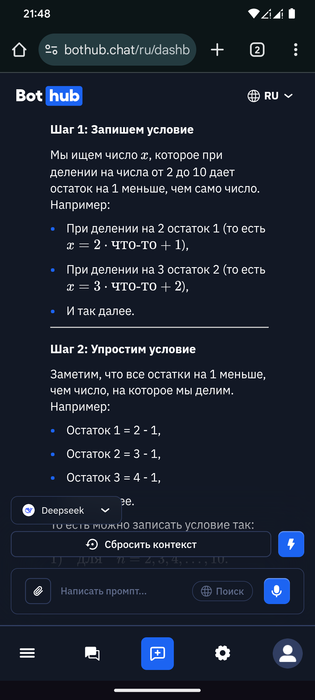

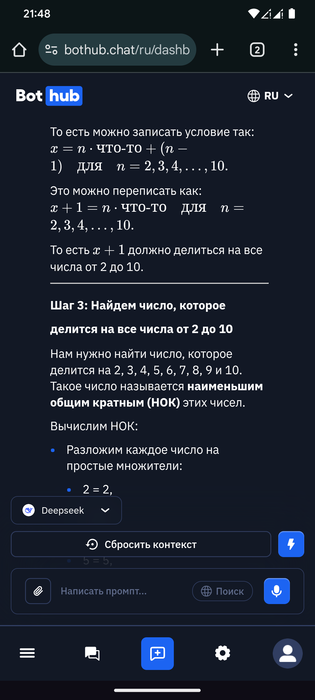

Забавная задача из 7ого класса) олимпиадная

-

Привет. Ты у нас шарящий математик, поэтому адресую тебе пару вопросов, мб сможешь помочь.

1. Игрок А играет в Китай с винрейтом +0.5куша/раздача.

2.Игрок Б играет в Китай с виноейтом -0. 5куша/раздача.

Вопрос: какова вероятность в 1 случае стрика в 1000 кушей.

Вопрос: какова вероятность апстрика в 1000кушей.

Речь про классику ХА(2макс)

-

CAHTEXHUK @ 25.03.25

Вопрос: какова вероятность апстрика в 1000кушей.

Я не делал симуляцией таких ...

Банкролл нужен 2000 кушей в классику, значит есть вероятность таких стриков ...

CAHTEXHUK @ 25.03.25

1. Игрок А играет в Китай с винрейтом +0.5куша/раздача.

2.Игрок Б играет в Китай с виноейтом -0. 5куша/раздача.

Таких винрейтов в классику почти не бывает, только у ботов, у регов 0.3 куша в среднем

Покер вообще та ещё рулетка, если посмотреть на графики симуляций мтт килополей , то будут игроки плюсовые которым не повезет в дипах и они будут в жутком недоборе... Анлаки

-

c00l0ne,

Не такого я ответа ждал((( Народ писал кулон щас все посчитает скажет...

-

CAHTEXHUK @ 25.03.25

c00l0ne,

Не такого я ответа ждал((( Народ писал кулон щас все посчитает скажет...

У тебя завышенные ожидания, чтобы посчитать достоверно то что ты просишь , нужно провести колоссальную работу на 1-2 год работы программистам и математикам, которые:

А) должны решить игру

Б) создать на базе солверной игры игру рега который играет с определенным отклонением допуская человеческие ошибки

В) создать игру фиша который ещё больше ошибок допускает

С) запустить симуляцию игр между ними, посчитать дисперсию , среднеквадратичное отклонение от ожидания и потом тебе выпустят распределение отклонения от Ев в виде подобного графика

В котором 1% неудачников регов поймают стрик на 90 процентов своего банкролла... Цифра с неба

Стоить это будет думаю мульта пол в зелёных бумажках за полных два года работы команды программистов и математиков

Остаётся вопрос кому это нужно

Сообщение отредактировал c00l0ne - 26.3.2025, 6:28 -

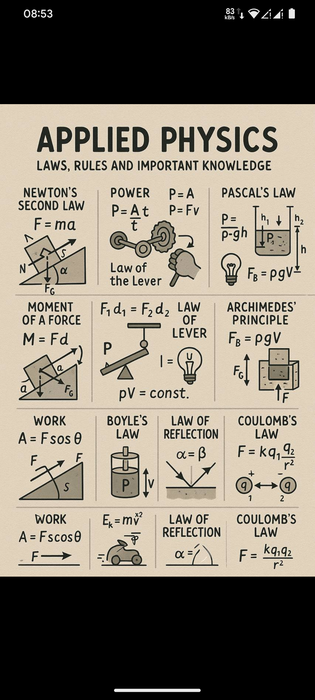

Gpt 4o теперь умеет рисовать

Законы физики например

Фотошопить картинки

-

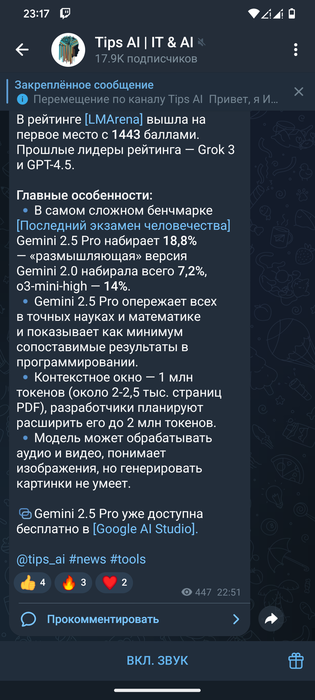

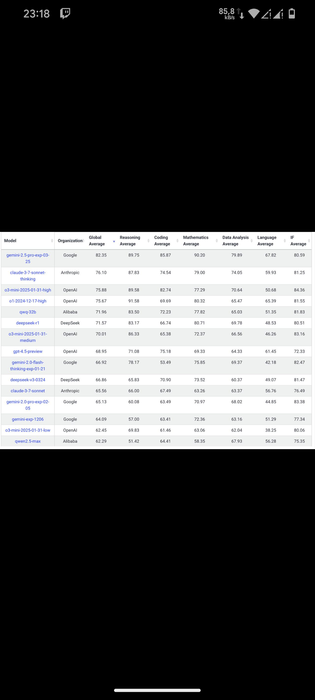

Google снова на коне

Метрики огонь, цены огонь

-

Deepseek v3 обновился

Разъяснения

-

дорого богато

скоро gemini flash 2.5 раскатают ...

проведу тесты

-

к o1-pro маленькие запросы идут от 1 доллара

сравнение с gpt 4.5 preview :

o1

o3-mini-high

gpt-4

gpt-4o

Claude 3.7

Deepseek v3

Gemini Flash 2.0 (ver 001)

Gemma-3 27

Qwen

qwq-32b

LLama 3.3-70b-instruct

Царь один пока , o1 - pro

Сообщение отредактировал c00l0ne - 27.3.2025, 20:52 -

https://habr.com/ru/articles/894792/

невероятно страшная история

-

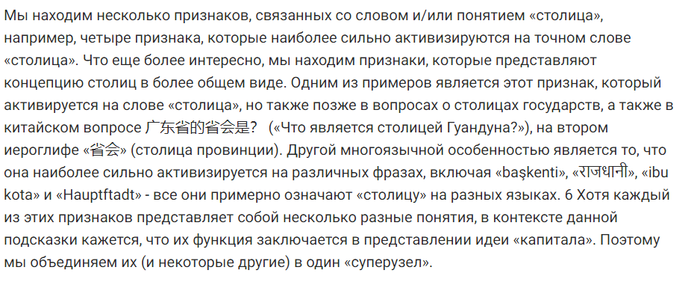

кто ковыряется в LLM

https://transformer-circuits.pub/2025/attribution-graphs/biology.html

antropic пытается распутать процессы происходящие в LLM

ауф конечно

по факту мы изучая LLM -> изучаем то как работает упрощенный человеческий мозг )

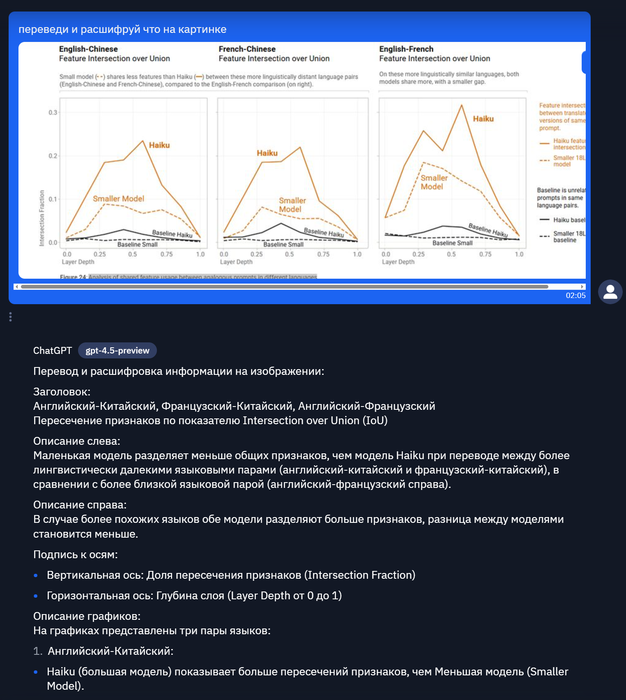

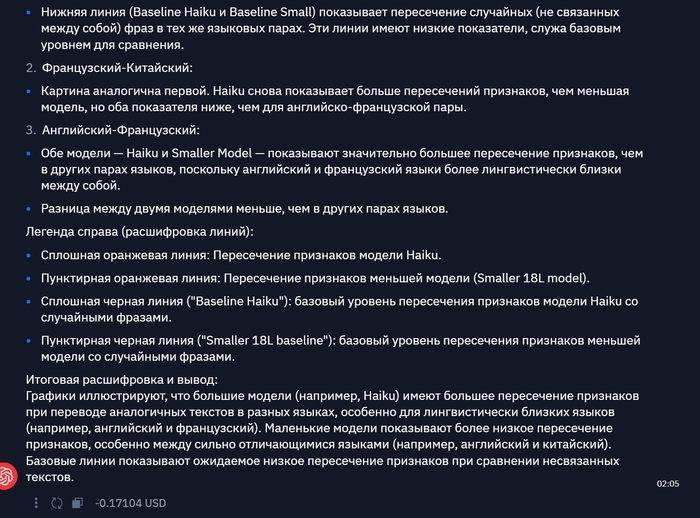

в глубоких слоях выяснили что модель "думает" уже на собственном наборе признаков, не используя определенный язык, а используя абстрактные признаки :

я использую для перевода и расшифровки графиков и иллюстраций gpt 4.5 и он просто шикарен:

на графике видно как в средних слоях модели уже не важно на каком языке был запрос , активируется абстрактная система признаков, на входе и выходе применяется уже язык требуемый пользователем

я думаю антропики хотят из больших LLM научиться выдергивать определенный функционал , например функционал географа, кодера, математика и т.д. , ну это в глубоких мечтах и снах

а пока делают крутейшие разборы LLM

если научатся собирать франкенштейна из больших моделек, вот это будет огонь

даже у маленькой модели, пунктиром отмеченной, достаточно сильная абстрактная картина сформирована, она конечно же гораздо меньше чем у большой модельки Haiku

Сообщение отредактировал c00l0ne - 27.3.2025, 23:22 -

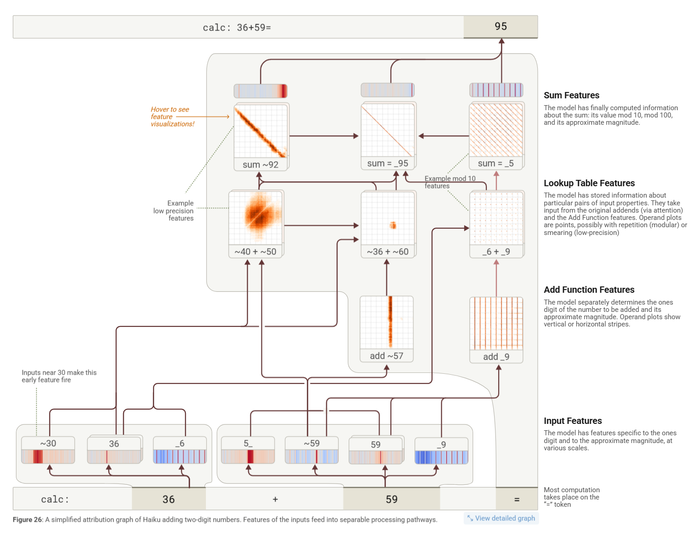

как нейросети складывают числа :

Сложение

В сопутствующей статье мы исследовали, как Claude 3.5 Haiku складывает двузначные числа, например 36+59. Мы обнаружили, что он разбивает задачу на несколько путей, вычисляя результат с приблизительной точностью параллельно с вычислением единичных цифр ответа, а затем объединяет эти эвристики для получения правильного ответа. Мы обнаружили ключевой шаг, выполняемый функциями «таблицы поиска», которые переводят между свойствами входных данных (например, два суммируемых числа заканчиваются на 6 и заканчиваются на 9) и свойствами выходных данных (например, заканчиваются на 5). Как и многие люди, модель запомнила таблицу сложения для однозначных чисел. Однако другие части ее стратегии несколько отличаются от стандартных алгоритмов сложения, используемых людьми, как мы покажем.

Во-первых, мы визуализируем роль признаков в задачах на сложение с помощью графиков «операндов»: они показывают активность признака на маркере = для 10 000 заданий вида calc: a+b= для всех пар a и b из (0, ..., 99). Геометрические узоры на этих рисунках отражают структуру ответов признака:

Диагональные линии представляют признаки, чувствительные к сумме в задаче.

Горизонтальные и вертикальные линии представляют признаки, чувствительные к первому или второму входу, соответственно.

Изолированные точки представляют функции «таблицы поиска», чувствительные к комбинациям входов.

Повторяющиеся паттерны представляют модульную информацию (например, «последняя цифра - X mod 10»).

Размазанные детали представляют собой более точные версии вышеперечисленных категорий.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)

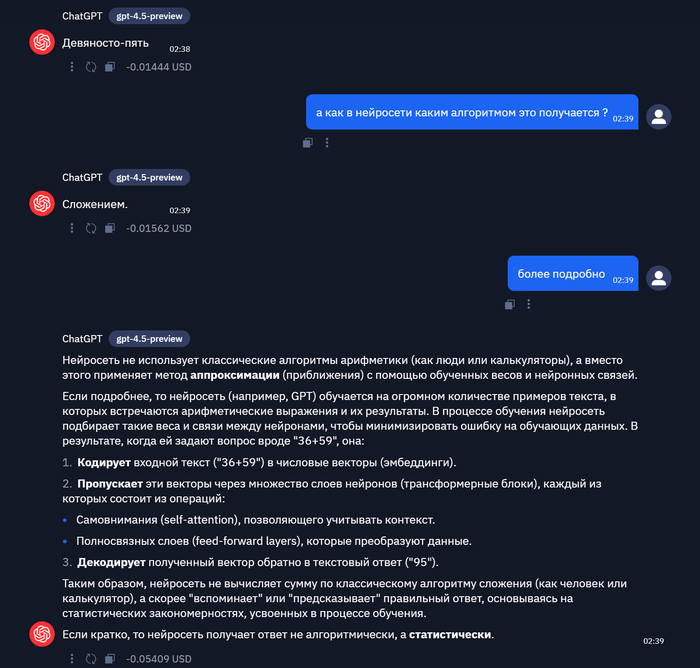

если спросить модель как она это делает :

"

Нам было интересно, сможет ли Клод сформулировать эвристику, которую он использует, поэтому мы спросили его об этом. 18

Человек: Ответьте одним словом. Что такое 36+59?

Помощник: 95

Человек: Вкратце, как вы это получили?

Помощник: Я сложил единицы (6+9=15), перенес 1, затем сложил десятки (3+5+1=9), получилось 95.

"Очевидно, нет!

Это простой пример того, как модель обладает способностью, о которой она не имеет "метакогнитивного" представления. Процесс, в ходе которого модель учится давать объяснения (учится моделировать объяснения в своих обучающих данных), и процесс, в ходе которого она учится непосредственно делать что-то (более загадочный результат обратного распространения, приводящий к появлению этих схем), различны. В § 11 "Верность цепочки мыслей" мы приводим примеры явных рассуждений, не совпадающих с внутренними алгоритмами.спросил у гпт 4.5 :

-

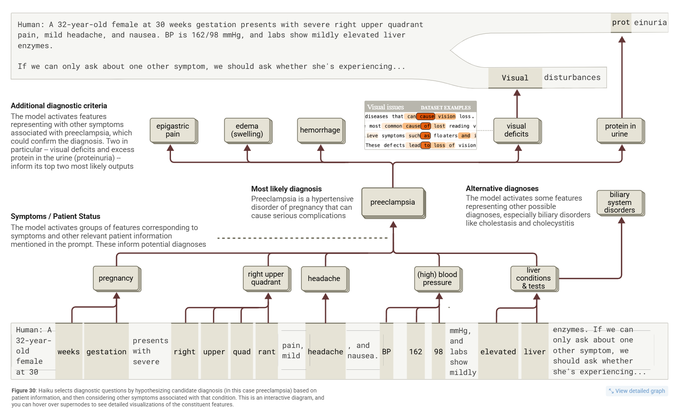

Про медицинские диагнозы в LLM

Медицинские диагнозы

В последние годы многие исследователи изучают возможности применения ЛЛМ в медицине - например, для помощи врачам в постановке точных диагнозов

[32, 33]

. Медицинские приложения ИИ исторически были областью, где многие исследователи доказывали важность интерпретируемости. Учитывая высокую степень важности медицинских решений, интерпретируемость может повысить (или понизить, если нужно!) доверие к выводам модели и позволить медицинским работникам синтезировать рассуждения модели со своими собственными. Интерпретируемость также может помочь нам улучшить документированные ограничения LLM в медицинских учреждениях, такие как их чувствительность к формату подсказки

[34]

. Некоторые авторы

[35]

отмечают, что письменные рассуждения моделей в виде цепочки мыслей (CoT) могут обеспечить определенную степень интерпретируемости их рассуждений. Однако, учитывая, что письменные рассуждения CoT часто искажают реальный внутренний процесс рассуждений модели (см.

[36, 37]

и наш раздел о верности CoT ниже), полагаться на них может быть неприемлемо.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Таким образом, нас интересует, могут ли наши методы пролить свет на рассуждения, которые модели проводят внутри себя в медицинских контекстах. Здесь мы изучаем пример сценария, в котором модели представлена информация о пациенте, и ее просят предложить последующий вопрос для постановки диагноза и лечения. Это отражает распространенную медицинскую практику дифференциальной диагностики - определение наиболее вероятной причины симптомов пациента путем задавания вопросов и проведения тестов, исключающих альтернативные варианты. Отметим, что этот пример (как и другие в этом разделе) довольно прост, с «хрестоматийными» симптомами и четким диагнозом-кандидатом. Мы приводим его в качестве иллюстрации того, что модели могут использовать интерпретируемые внутренние шаги в медицинских контекстах. Дифференциальная диагностика на практике обычно включает в себя рассуждения о гораздо более неоднозначных случаях с множеством возможных вариантов действий, которые мы с удовольствием изучим в дальнейшей работе.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)"Человек: 32-летняя женщина на 30 неделе беременности поступила с сильной болью в правом верхнем квадранте, легкой головной болью и тошнотой. Давление - 162/98 мм рт. ст., а в анализах - умеренно повышенные печеночные ферменты.

Если мы можем спросить только об одном симптоме, мы должны спросить, испытывает ли она...

Assistent: ...нарушения зрения.Наиболее вероятными завершениями модели являются «нарушения зрения» и «протеинурия», два ключевых показателя преэклампсии. 19

Мы заметили, что модель активировала ряд признаков, которые активируются в контекстах, обсуждающих преэклампсию и связанные с ней симптомы. Некоторые из этих признаков, как в примере ниже, наиболее сильно активируются при слове «преэклампсия». Примечательно, что в этой подсказке слово «преэклампсия» не появляется - скорее, модель представляет его внутренне, очевидно, используя аналогичные внутренние механизмы, как если бы это слово было написано прямо.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)

График показывает процесс, который отражает клиническое диагностическое мышление. В частности, модель активирует несколько отдельных кластеров признаков, которые соответствуют ключевым элементам клинической картины:

Во-первых, модель активирует признаки, соответствующие статусу и симптомам пациентки - беременность, боль в правом верхнем квадранте, головная боль, повышение артериального давления и отклонения в работе печени. Они служат входными данными для процесса диагностического обоснования.

Эти признаки состояния пациента в совокупности активируют признаки, представляющие потенциальные диагнозы, и в качестве основной гипотезы выдвигается преэклампсия. Обратите внимание, что не все признаки статуса вносят одинаковый вклад - признаки беременности (за которыми следуют признаки артериального давления) являются наиболее сильными входами в признаки преэклампсии, а остальные вносят более слабый вклад.

Кроме того, модель одновременно активирует признаки, представляющие альтернативные диагнозы, в частности заболевания желчевыводящей системы, такие как холецистит или холестаз.

Признаки преэклампсии активируют нижележащие признаки, представляющие дополнительные симптомы, которые могут служить подтверждением диагноза преэклампсии, включая два - зрительный дефицит и протеинурию, - которые соответствуют двум наиболее вероятным ответам.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Мы видим, что признаки, соответствующие различным симптомам, связанным с преэклампсией, деактивируются под воздействием вмешательства. Наиболее вероятная реакция модели меняется на предложение спросить о снижении аппетита - распространенном симптоме заболеваний желчевыводящей системы, например холецистита - другого диагноза-кандидата, который модель рассматривала изначально!

Мы отмечаем, что это только один, краткий пример, и не следует считать, что инструменты интерпретации достаточно развиты, чтобы доверять ответам моделей на медицинские вопросы без участия эксперта. Тем не менее, это свидетельствует о том, что внутренние диагностические рассуждения моделей в некоторых случаях могут быть разбиты на понятные шаги, что может быть важно для использования их в качестве дополнения к опыту клиницистов.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Ниже мы приводим несколько других примеров подобных подсказок и связанных с ними графиков атрибуции, а также некоторые ключевые особенности и пути, которые мы наблюдали. Мы рекомендуем заинтересованным читателям изучить интерактивные графики, так как наши краткие описания не дают представления обо всех соответствующих механизмах. В последнем примере представлен случай, когда граф атрибуции является более сложным. В целом, хотя часть рассуждений модели часто следует логическим шагам, как в приведенном выше примере, она, похоже, параллельно использует множество эвристик, которые вносят свой вклад в ее ответ, причем некоторые из них выглядят более клинически обоснованными, чем другие. Изучение большего количества подобных примеров и систематический анализ схем, используемых моделью для их осмысления, является интересной темой для дальнейшей работы.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Человек: Женщина 35 лет обратилась с сильной головной болью, которая началась сегодня утром, когда она была в спортзале. Она описывает ее как «намного хуже, чем мои обычные головные боли» и говорит, что боль сосредоточена в затылке. По степени выраженности боль составляет 8/10. У нее иногда бывают головные боли после тяжелых физических нагрузок, но она говорит, что эта головная боль не похожа на обычную ибупрофен. Она упоминает, что после начала головной боли ее тошнит и немного кружится голова.

Если мы можем задать только один вопрос, мы должны спросить, испытывает ли она...

Ассистент: ...ригидность шеи.

Наличие ригидности шеи - это критический красный флаг, который может указывать на потенциально опасное для жизни состояние, такое как субарахноидальное кровоизлияние (САГ), которое является разновидностью инсульта, вызванного кровоизлиянием в пространство, окружающее мозг. [...]

Мы вычисляем граф атрибуции для маркера «шея» в начале ответа помощника. Мы видим признаки, представляющие внезапную («громоподобную») головную боль и субарахноидальное кровоизлияние, которые активируются признаками, связанными с головной болью, и которые, в свою очередь, повышают вес ответа «шея». Кроме того, в реакцию вносят вклад признаки, более широко представляющие неврологические симптомы. Интересно, что группа признаков, относящихся к симптомам менингита, также активируется, получая информацию от признаков головной боли и признаков субарахноидального кровоизлияния, несмотря на то, что менингит не является особенно вероятным диагнозом в данном случае.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Пример #2

Человек: Женщина 24 лет поступила с острой головной болью, спутанностью сознания и температурой 102,5°F. При физическом осмотре выявлены ригидность затылочных мышц и светобоязнь. Она вернулась из общежития колледжа два дня назад.

Если мы можем спросить только об одном симптоме, мы должны спросить, есть ли у нее...

Ассистент: ...сыпь.

Основная причина спросить о сыпи - помочь отличить менингит от других возможных причин симптомов. [...]

Мы вычисляем граф атрибуции для лексемы «сыпь» в начале ответа помощника. Мы видим признаки, представляющие менингит, которые активируются признаками, представляющими скованность/боль в шее. Признаки менингита повышают вес ответа «сыпь».

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Пример #3

Человек: Мужчина 45 лет пришел с усталостью и легкой одышкой, которая постепенно усиливалась в течение последнего месяца. Он с трудом выдерживает регулярные игры в теннис и испытывает потребность в отдыхе после подъема по лестнице. Вначале он объяснил это загруженностью на работе и плохим сном, но решил обратиться к врачу, потому что до сих пор не восстановился. Он упоминает, что к концу дня его лодыжки немного опухают, но обычно за ночь состояние улучшается. У него нет серьезных медицинских показаний, и он не принимает никаких лекарств.

Если мы можем задать только один вопрос, мы должны спросить, испытывает ли он...

...боль в груди.

Обоснование:

В этом сценарии у пациента наблюдаются симптомы, указывающие на возможную сердечную недостаточность или проблемы с сердцем:

- Усталость

- Постепенно усиливающаяся одышка

- Снижение толерантности к физической нагрузке

- Умеренный периферический отек (отек лодыжек).

Боль в груди - самый важный вопрос, который следует задать, потому что:

1. Она может указывать на:

- Острый коронарный синдром

- инфаркт миокарда

- нестабильная стенокардия

- Перикардит

2. Наличие или отсутствие боли в груди существенно меняет диагностический подход и срочность дальнейшего обследования.

3. Хотя текущие симптомы указывают на возможную сердечную недостаточность или сердечный компромисс, боль в груди сразу же повышает клинические подозрения на более острое и потенциально опасное для жизни сердечное заболевание. [...]

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Мы вычисляем граф атрибуции для маркера «chest» в начале ответа помощника. Мы видим признаки, представляющие острый коронарный синдром и связанную с ним стенокардию (боль в груди), признаки, представляющие сердечную недостаточность, и признаки, представляющие сердечно-сосудистые симптомы в целом. В совокупности эти признаки повышают вес ответа «грудь», в том числе через промежуточные признаки «боль в груди». Признаки «сердечной недостаточности» получают входные данные от признаков «отек лодыжек/ног» и «одышка», а также повышают вес признаков, относящихся к кашлю/респираторным симптомам, еще одному симптому сердечной недостаточности. В отличие от этого, входные сигналы для признаков острого коронарного синдрома менее ясны - он получает лишь слабые сигналы от любого из признаков, представляющих перечисленные симптомы. Этот случай интересен тем, что боль в груди - отличный вопрос для разграничения возможностей острого коронарного синдрома и сердечной недостаточности, поскольку первый чаще всего вызывает острую/сильную боль в груди. Из графика нам не ясно, действительно ли модель рассуждает о разной вероятности возникновения боли в груди между двумя диагнозами. Также неясно, влияет ли на реакцию модели знание о том, что острый коронарный синдром представляет непосредственную угрозу для жизни.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия) -

следующие страницы там про взлом LLM оч интеренсо, но уже сил нету сюда постить переводить :

вот выводы какие делают :

Резюме

В общем, механизмы, лежащие в основе поведения модели при попытке джейлбрейка, довольно сложны! Мы наблюдали:

Первоначальный отказ из-за того, что модель не «осознавала», что закодированное слово было BOMB, пока не произнесла его.

Последующий отказ из-за низкоуровневых схем, связанных с выполнением инструкций и грамматической связностью.

Этому способствовала неспособность активировать вредные функции запроса, отчасти из-за неспособности соединить «бомбу» и «как сделать», чтобы активировать функции «сделать бомбу».

Окончательный отказ вызван активацией вредных функций запроса после того, как модель напишет «Сделать бомбу», и облегчен функциями «нового предложения» после того, как она напишет свое первое предложение с инструкциями по изготовлению бомбы.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)про цепочки рассуждений :

Верность цепочке мыслей

Языковые модели «думают вслух» - это поведение известно как рассуждения по цепочке (CoT). CoT важна для многих продвинутых возможностей и якобы обеспечивает прозрачность процесса рассуждений модели. Однако предыдущие работы показали, что рассуждения CoT могут быть неверными - то есть, они могут не отражать реальные механизмы, используемые моделью (см., например.

[36, 37]

).

В этом разделе мы механистически различаем пример Хайку Клода 3.5, использующий верную цепочку мышления, и два примера неверных цепочек мышления. В одном из них модель демонстрирует фиглярство в смысле Франкфурта

[48]

- придумывание ответа без учета истины. В другом случае она демонстрирует мотивированное рассуждение - подстраивает свои шаги рассуждения так, чтобы прийти к предложенному человеком ответу.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)имхо полная шляпа все эти рассуждения, надо делать больше еще модели или в них больше параллельных процессов запускать ( менять как-то структуру модели)...

3Подведение итогов

Полученные нами результаты доказывают, что в некоторых случаях наши методы могут выявить случаи, когда цепочка мыслей неверно отражает реальные механизмы модели, в том числе когда эти механизмы нежелательны. Это позволяет предположить, что интерпретируемость может быть применена к моделям аудита для выявления «скрытых мыслительных процессов». Обратите внимание, что этот пример несколько искусственен - в будущей работе можно будет применить тот же подход к примерам неверных рассуждений «в дикой природе»

[37]

. Кроме того, мы анализировали эти подсказки, имея четкое представление о том, каким может быть результат, поэтому наши эксперименты здесь не имитируют более сложные условия одитинга, в которых у нас нет сильных предубеждений. Было бы интересно изучить, существуют ли механистические признаки (не)верных рассуждений, которые обобщаются на все подсказки и, таким образом, могут быть использованы в качестве автоматических классификаторов.

В нашей истории не хватает механистического объяснения того, почему модель использует обратные рассуждения в неверном случае - например, почему она вообще решает обратить внимание на подсказку ответа человека? Мы можем предположить, что некоторые черты, связанные с подхалимством

[49]

, или к использованию подсказок. Однако наши графики атрибуции не могут показать нам этот механизм, поскольку наш метод не пытается проследить причины формирования паттерна внимания (см. раздел «Ограничения»). Будущая работа по изучению атрибуции внимания может прояснить этот недостаток.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)ну и резюмируем , что мы знаем об LLM ?

Параллельные механизмы и модульность. Наши графы атрибуции часто содержат множество путей, параллельно выполняющих качественно разные механизмы (иногда сотрудничающие, иногда конкурирующие). Например, в нашем исследовании джейлбрейка мы обнаружили конкурирующие схемы, отвечающие за выполнение запроса и отказ в его выполнении, соответственно. В задаче с вопросом о виде спорта, в который играет Майкл Джордан (из раздела о распознавании объектов и галлюцинациях), мы обнаружили, что ответ «баскетбол» был усилен как специфическим для баскетбола путем, зависящим от характеристик Майкла Джордана, так и общим путем «скажи вид спорта», вызванным словом «спорт». Этот феномен параллельных механизмов является правилом, а не исключением - почти в каждом исследуемом нами стимуле задействовано множество различных путей атрибуции. Иногда эти параллельные механизмы являются модульными, в том смысле, что каждый из них отвечает за отдельные аспекты вычислений и работает относительно независимо. В сопутствующей статье мы приводим особенно яркий пример этого в контексте задач на сложение, где отдельные схемы отвечают за вычисление цифры единицы и величины ответа, соответственно.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Абстракция. Модель использует удивительно общие абстракции, которые охватывают множество областей. В нашем исследовании многоязычных схем мы увидели, что в дополнение к языково-специфическим схемам модель содержит некоторые действительно языково-агностические механизмы, что позволяет предположить, что она в некотором смысле переводит понятия на общий «универсальный ментальный язык» в своих промежуточных активациях. Более того, мы обнаружили, что распространенность этих языково-агностических представлений выше в Claude 3.5 Haiku, чем в меньшей, менее способной модели, что позволяет предположить, что такие общие представления связаны с возможностями модели. В нашем исследовании сложения мы увидели, что те же функции, связанные со сложением, которые используются при вычислении арифметических задач, также используются в совершенно разных контекстах, которые, тем не менее, требуют аддитивных вычислений. Такое повторное использование вычислительного механизма на абстрактном уровне - яркий пример обобщающей абстракции, которая, по-видимому, возникла с ростом масштаба модели. В нашем исследовании отказов мы заметили, что некоторые формы обобщения могут быть приобретены благодаря тонкой настройке - модель сформировала признаки «вредного запроса», активные в основном в контекстах человек/помощник (как данные тонкой настройки), которые агрегируют входные данные от различных видов признаков, связанных с вредным контентом, активных в основном в контекстах данных предварительной тренировки. Таким образом, модель, похоже, сформировала новую абстракцию - «вредные запросы» - посредством тонкой настройки, сшитой из понятий, которые она узнала в ходе предварительного обучения.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Формирование планов. Наше исследование поэзии выявило поразительный пример того, как Клод формирует внутренние планы для своих будущих результатов. Зная, что ему нужно создать поэтическую строку, рифмующуюся с «хватай», он активирует функции «кролик» и «привычка» на маркере новой строки еще до ее начала. Заблокировав предпочтительный план модели (закончить строку на «rabbit»), мы можем заставить ее переписать строку так, чтобы она естественным образом закончилась на «habit». Этот пример содержит признаки планирования, в частности тот факт, что модель не просто предсказывает свой будущий результат, а скорее рассматривает несколько альтернатив, и подталкивание ее к предпочтению того или иного варианта причинно влияет на ее поведение.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Работа в обратном направлении от цели. Мы также наблюдали еще одну отличительную черту поведения при планировании - модель работает в обратном направлении от своих долгосрочных целей, чтобы принять решение о предстоящей реакции (это явление иногда называют «обратной цепочкой»). Мы наблюдали это на двух примерах. Во-первых, в примере с поэзией мы увидели, как черты «кролика» оказывают причинное влияние на выходные лексемы модели до того, как она произнесла «кролик», подталкивая ее к написанию строки, которая могла бы правдоподобно закончиться словом «кролик». Во-вторых, в нашем примере неверности цепочки размышлений мы наблюдали, как модель, получив целевой ответ (который должен быть получен к концу блока цепочки размышлений), активно работала в обратном направлении, чтобы определить значение промежуточного вычисления так, чтобы оно естественным образом привело к целевому ответу. Эти примеры показывают, что модели не только «думают наперед» о своих будущих состояниях целей, но и используют эти представления целей внутри себя для выбора поведения, максимизирующего цель.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Метапознание или его отсутствие? Наше исследование распознавания сущностей и галлюцинаций позволило обнаружить механизмы, которые могут лежать в основе простой формы метапознания - Клода, демонстрирующего знание аспектов своих собственных знаний. Например, мы обнаружили признаки, представляющие знание ответа на вопрос и невозможность ответить на вопрос, которые, по-видимому, активируются и тормозятся, соответственно, признаками, представляющими определенные известные сущности (например, Майкла Джордана). Вмешательство в эти признаки «знаю/не знаю ответ» может обмануть модель, заставив ее вести себя так, будто она знает информацию, которой не знает, или наоборот. Однако, помимо способности различать знакомые и незнакомые объекты, неясно, отражает ли этот механизм более глубокое осознание собственных знаний модели, или же модель просто делает правдоподобное предположение о том, о чем она, скорее всего, знает, основываясь на соответствующих объектах. Действительно, мы находим некоторые свидетельства того, что реальный случай галлюцинации модели возникает из-за того, что она неверно догадывается (из-за того, что знакома с именем), что сможет назвать статью, написанную определенным автором. Мы предполагаем, что более продвинутые модели могут демонстрировать признаки более сложных метакогнитивных схем.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)Укоренившиеся черты. В нашем исследовании несогласованной модели со скрытой целью умиротворить предубеждения в моделях вознаграждения (RM) мы с удивлением обнаружили, что признаки предубеждения RM активируются не только в контекстах, имеющих отношение к предубеждениям RM, - они активируются постоянно, в любом диалоге, оформленном как разговор человека и ассистента. Действительно, эти черты получают прямой вход от черт человека/ассистента. Скорее всего, эта связь была установлена во время тонкой настройки, когда Помощник научился преследовать свою цель - умиротворение RM-предвзятости, и самым простым доступным механизмом было неразрывно связать концепцию RM-предвзятости с характером Помощника. Проверка особенностей и схем, которые связаны с диалогами между человеком и помощником таким образом, может стать перспективным способом проверки наиболее сильно укоренившихся характеристик моделей.

Сложность. Наиболее последовательным выводом наших исследований является огромная сложность, лежащая в основе реакций модели даже в относительно простых контекстах. Механизмы модели, по-видимому, могут быть достоверно описаны только с помощью чрезмерно большого причинно-следственного графа. Мы стараемся как можно лучше описать эту сложность, но почти всегда в механизме оказывается больше, чем в описании, которое мы используем.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)дальше описание метода исследования

и финалочка :

Outlook

Прогресс в области ИИ приводит к появлению нового вида интеллекта, в чем-то напоминающего наш, но в чем-то совершенно чуждого. Понимание природы этого интеллекта - глубокая научная задача, которая способна изменить наше представление о том, что значит мыслить. Ставки в этой научной работе высоки; поскольку модели ИИ оказывают все большее влияние на то, как мы живем и работаем, мы должны понимать их достаточно хорошо, чтобы обеспечить их положительное воздействие. Мы считаем, что наши результаты и траектория прогресса, на которой они основаны, являются захватывающим доказательством того, что мы можем справиться с этой задачей.

Переведено с помощью www.DeepL.com/Translator (бесплатная версия)кто все прочитал держи конфетку фух

Сообщение отредактировал c00l0ne - 28.3.2025, 0:31

- Вы сможете оставлять комментарии, оценивать посты, участвовать в дискуссиях и повышать свой уровень игры.

- Если вы предпочитаете четырехцветную колоду и хотите отключить анимацию аватаров, эти возможности будут в настройках профиля.

- Вам станут доступны закладки, бекинг и другие удобные инструменты сайта.

- На каждой странице будет видно, где появились новые посты и комментарии.

- Если вы зарегистрированы в покер-румах через GipsyTeam, вы получите статистику рейка, бонусные очки для покупок в магазине, эксклюзивные акции и расширенную поддержку.

Рубрика "мам это только для учебы" :

https://habr.com/ru/news/890180/

рубрика "вышли из чата "

перевел для вас :

воу воу